El lunes, Gizmodo descubrió que el gigante de las búsquedas actualizó su política de privacidad para revelar que sus diversos servicios de IA, como Bard y Cloud AI, pueden ser entrenados con datos públicos que la empresa ha obtenido de la web.

“Nuestra política de privacidad ha sido transparente durante mucho tiempo, en el sentido de que Google utiliza información disponible públicamente en la web para entrenar modelos de lenguaje para servicios como Google Translate”, dijo Christa Muldoon, portavoz de Google. “Esta última actualización simplemente aclara que también se incluyen servicios más nuevos como Bard. Incorporamos principios y salvaguardias de privacidad en el desarrollo de nuestras tecnologías de IA, de acuerdo con nuestros Principios de IA.”

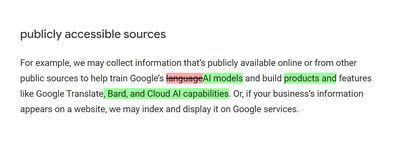

Después de la actualización del 1 de julio de 2023, la política de privacidad de Google ahora dice que “Google utiliza la información para mejorar nuestros servicios y desarrollar nuevos productos, funciones y tecnologías que beneficien a nuestros usuarios y al público” y que la empresa puede “utilizar información disponible públicamente para ayudar a entrenar los modelos de IA de Google y construir productos y características como Google Translate, Bard y Cloud AI.”

Puedes ver en el historial de revisiones de la política que la actualización proporciona una mayor claridad sobre los servicios que se entrenarán utilizando los datos recopilados. Por ejemplo, el documento ahora dice que la información puede ser utilizada para "Modelos de IA" en lugar de "modelos de lenguaje", lo que otorga a Google más libertad para entrenar y construir sistemas además de los LLM en tus datos públicos. E incluso esa nota está enterrada bajo un enlace incrustado para "fuentes de acceso público" debajo de la pestaña "Tu información local" de la política que debes hacer clic para abrir la sección relevante.

La política actualizada especifica que la “información disponible públicamente” se utiliza para entrenar los productos de IA de Google, pero no dice cómo (o si) la empresa evitará incluir materiales con derechos de autor en ese conjunto de datos. Muchos sitios web de acceso público tienen políticas que prohíben la recopilación de datos o el scraping web con fines de entrenamiento de grandes modelos de lenguaje y otras herramientas de IA. Será interesante ver cómo se desarrolla este enfoque con diversas regulaciones globales como GDPR que protegen a las personas contra el mal uso de sus datos sin su permiso expreso.

La combinación de estas leyes y la competencia creciente en el mercado ha llevado a los fabricantes de sistemas populares de IA generativa como GPT-4 de OpenAI a ser extremadamente cautelosos sobre dónde obtuvieron los datos utilizados para entrenarlos y si incluyen o no publicaciones en redes sociales o obras con derechos de autor de artistas y autores humanos.

La cuestión de si la doctrina del uso legítimo se aplica a este tipo de aplicación actualmente se encuentra en un área legal gris. La incertidumbre ha provocado varias demandas y ha llevado a los legisladores de algunos países a introducir leyes más estrictas que estén mejor equipadas para regular cómo las empresas de IA recopilan y utilizan sus datos de entrenamiento. También plantea preguntas sobre cómo se está procesando estos datos para garantizar que no contribuya a fallas peligrosas dentro de los sistemas de IA, ya que las personas encargadas de clasificar estos vastos conjuntos de datos de entrenamiento a menudo están sujetas a largas horas y condiciones de trabajo extremas.